ChatGPT ist down. Gut so: Mit lächelnden Emojis und Komplimenten mag ChatGPT uns schmeichelnd in Watte packen. Warum es aber nie unser Team-Partner wird, hat Autorin Vauhini Vara durch ihr neues Buch „Searches“ am eigenen Leibe erfahren

Große Technologieunternehmen haben die menschliche Sprache für KI-Zwecke ausgenutzt. Jetzt wollen sie, dass wir ihre Produkte als vertrauenswürdige Kollaborateure betrachten

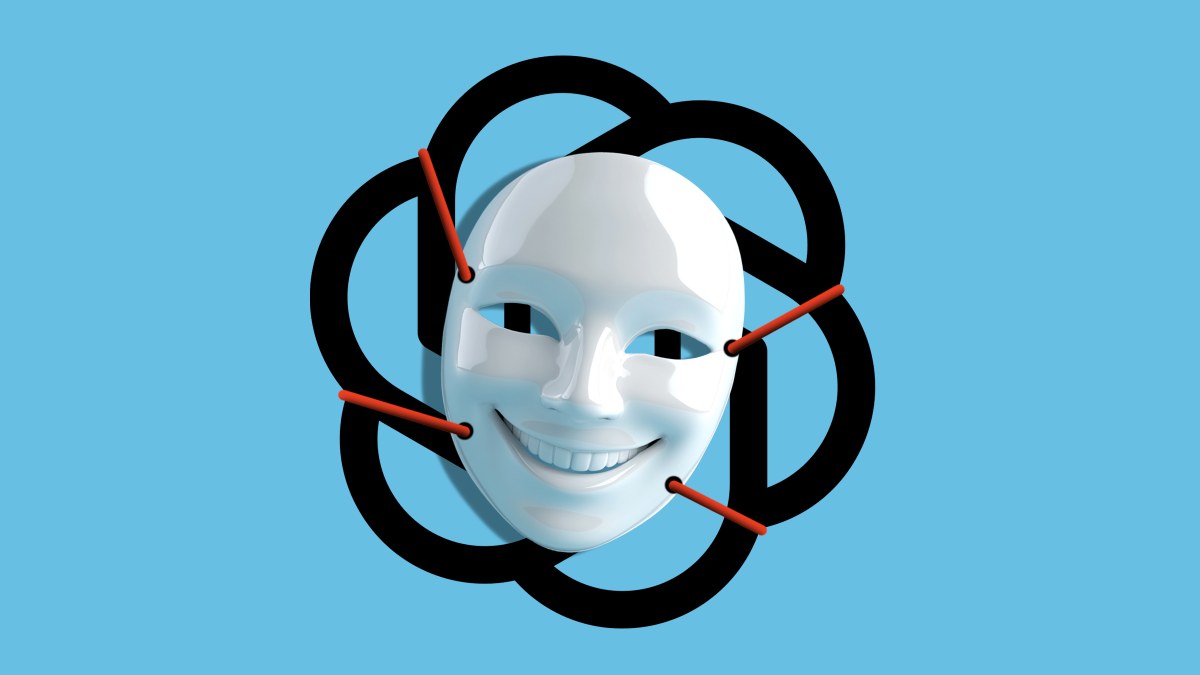

Illustration: ChatGPT/der Freitag

Nachdem ich Anfang April mein drittes Buch Searches veröffentlicht hatte, stieß ich immer wieder auf Schlagzeilen, durch die ich mich wie die Protagonistin einer Black-Mirror-Folge fühlte. „Vauhini Vara hat ChatGPT zurate gezogen, um ihr neues Buch Searches zu schreiben“, hieß es. Die Veröffentlichungen, die Searches auf diese Weise beschrieben, waren seriös und faktenbasiert. Aber ihre Beschreibungen meines Buches und der Rolle von ChatGPT darin stimmten nicht überein.

Ich hatte zwar ChatGPT-Gespräche in das Buch aufgenommen, mein Ziel war aber die Kritik und nicht die Zusammenarbeit. In Interviews und bei öffentlichen Veranstaltungen hatte ich wiederholt davor gewarnt, große Sprachmodelle wie die hinter ChatGPT zur Hilfe bei d

ches und der Rolle von ChatGPT darin stimmten nicht überein. Ich hatte zwar ChatGPT-Gespräche in das Buch aufgenommen, mein Ziel war aber die Kritik und nicht die Zusammenarbeit. In Interviews und bei öffentlichen Veranstaltungen hatte ich wiederholt davor gewarnt, große Sprachmodelle wie die hinter ChatGPT zur Hilfe bei der Selbstdarstellung zu verwenden. Wurde ich etwa missverstanden? Große Technologieunternehmen nutzen die menschliche Sprache zu ihrem Vorteil. Ich würde behaupten, dass wir dies zulassen, weil wir auch einen gewissen Nutzen aus der Verwendung der Produkte ziehen. Diese Dynamik macht uns mitschuldig an der Anhäufung von Reichtum und Macht durch Big Tech: Wir sind sowohl Opfer als auch Nutznießer. Ich beschreibe diese Komplizenschaft in meinem Buch, führe sie aber auch vor, und zwar durch meine Google-Suchen, meine Amazon-Produktbewertungen und ja auch durch meine ChatGPT-Dialoge.Mein Kollege, die KIAls ich ChatGPT bat, mir Feedback zu einigen meiner Kapitel zu geben, war mein Ton höflich, sogar fast schüchtern: „Ich bin nervös“, behauptete ich. OpenAI, die Firma hinter ChatGPT, sagt, ihr Produkt sei so geschaffen, dass es die Anweisungen gut befolgen sollte. Untersuchungen legen nahe, dass ChatGPT am gehorsamsten ist, wenn wir freundlich sind. Also formulierte ich meine eigenen Anfragen mit guten Manieren. Wenn es mir ein Kompliment machte, bedankte ich mich höflich. Wenn ich es auf sachliche Fehler hinwies, hielt ich mich mit Urteilen zurück. ChatGPT war ebenfalls von vornherein auf Höflichkeit aus. Die Textausgabe von Chatbots wird oft als „fade“ oder „generisch“ beschrieben – geradezu wie das sprachliche Äquivalent eines beigen Bürogebäudes. Die Produkte von OpenAIsind so konzipiert, dass sie „wie ein Kollege klingen“, wieOpenAI es ausführt. Dabei wird eine Sprache verwendet, die, wenn sie von einem Menschen käme, „höflich“, „einfühlsam“, „freundlich“, „rational“, „optimistisch“ und „einnehmend“ klingen würde. OpenAI beschreibt diese Strategien so, dass ihre Produkte „professionell“ und „ansprechbar“ erscheinen. Dies scheint damit zusammenzuhängen, dass wir uns sicher fühlen: „Die Standardpersönlichkeit von ChatGPT hat einen großen Einfluss auf die Art und Weise, wie Sie es erleben und ihm vertrauen“, postete OpenAI kürzlich in einem Blog, in dem es die Rücknahme eines Updates erklärte, das ChatGPT unheimlich unterwürfig klingen ließ.Mit kollegialer Neutralität verschiebt die KI den eigenen StandpunktVertrauen ist für Unternehmen im Bereich der künstlichen Intelligenz (KI) eine Herausforderung, auch weil ihre Produkte regelmäßig Unwahrheiten produzieren und sexistische, rassistische und US-zentrische kulturelle Normen reproduzieren und damit verfestigen. Die Unternehmen arbeiten zwar an diesen Problemen, aber sie bleiben bestehen: OpenAI hat festgestellt, dass seine neuesten Systeme eine höhere Fehlerquote aufweisen als ihre vorherigen.Als ich Microsofts Bing Image Creatoraufforderte, ein Bild von Ingenieuren und Weltraumforschern zu erstellen, generierte es diese mit einer durchweg männlichen Besetzung. Als mein Vater ChatGPT bat, seine Texte zu bearbeiten, verwandelte es sein perfektes indisches Englisch in amerikanisches. Dies war kein Zufall. Untersuchungen zeigen, dass beide Tendenzen durchaus weit verbreitet sind.In meinen eigenenChatGPT-Dialogen wollte ich aufzeigen, wie der Anschein kollegialer Neutralität des Produkts uns dazu verleiten kann, falsche oder voreingenommene Antworten ohne viel kritisches Hinterfragen zu übernehmen. Im Laufe der Zeit schien michChatGPT dazu zu bewegen, ein positiveres Buch über Big Tech zu schreiben. Einschließlich der Änderung meiner Beschreibung des CEO von OpenAI, Sam Altman, um ihn als „Visionär und Pragmatiker“ zu bezeichnen. Sam Altman und sein ChatbotMir sind keine Untersuchungen darüber bekannt, ob ChatGPT dazu neigt, Big Tech, OpenAIoder Altman zu bevorzugen – es lässt sich aber vermuten, weswegen es in unserem Gespräch so schien. OpenAI erklärt ausdrücklich, dass ihre Produkte nicht versuchen sollen, das Denken ihrer User zu beeinflussen. Als ich ChatGPT zu einigen der Probleme befragte, gab es den Verzerrungen in seinen Trainingsdaten die Schuld – obwohl ich denke, dass auch meine Fragen eine Rolle spielten. Als ich ChatGPTzu seiner Rhetorik befragte, antwortete es: „Die Art und Weise, wie ich kommuniziere, soll das Vertrauen in meine Antworten fördern, was sowohl hilfreich als auch potenziell irreführend sein kann.“ Dennoch schlug ChatGPT am Ende unseres Dialogs ein Ende für mein Buch vor, in dem Altman mir sagt: „KI kann uns Werkzeuge geben, um unsere Menschlichkeit auf ungeahnte Weise zu erforschen. Es liegt an uns, sie weise zu nutzen.“ Altman hat dies mir gegenüber nie erwähnt, obwohl es sich mit einem gängigen Argument deckt, welches unsere Verantwortung gegenüber den Unzulänglichkeiten von KI-Produkten betont.Ich dachte, ich würde die Maschine kritisieren. Die Schlagzeilen beschrieben uns aber als kollaborierend. Jedes Mal, wenn ich bei Interviews und bei öffentlichen Auftritten auf meine angebliche Zusammenarbeit mit ChatGPT angesprochen wurde, verwies ich auf die Begriffsdefinition desCambridge Dictionary: „Zusammenarbeit ist die Situation, in der zwei oder mehr Personen zusammenarbeiten, um die gleiche Sache zu schaffen oder zu erreichen“. Egal, wie menschlich die Rhetorik der KI auch sein mag, eine Person ist sie nicht. Damit ist ChatGPT weder in der Lage, mit mir zusammenzuarbeiten, noch meine Ziele zu teilen.Die Ziele von OpenAIOpenAI hat natürlich seine eigenen Ziele. Eines davon ist der Wunsch, KI zu entwickeln, die „der gesamten Menschheit zugutekommt“. Aber auch wenn das Unternehmen von einer gemeinnützigen Organisation mit dieser Mission kontrolliert wird, wollen seine Geldgeber dennoch eine Rendite für ihre Investition erzielen. Dazu ist es vermutlich erforderlich, dass die Menschen solche Produkte wie ChatGPT noch mehr nutzen als bisher. Dies lässt sich eher erreichen, wenn die Menschen die Produkte als vertrauenswürdige Partner ansehen. Letztes Jahr stellte sich Altman vor, dass sich KI wie ein „superkompetenter Kollege verhält, der absolut alles über mein ganzes Leben weiß“. In einem Ted-Interview im April dieses Jahres deutete er an, dass dies sogar auf gesellschaftlicher Ebene funktionieren könnte: „Ich glaube, dass KI uns helfen kann, klüger zu sein und bessere kollektive Entscheidungen zu treffen, als bislang.“ Bei einer Anhörung des US-Senats diesen Monat ließ er die hypothetischen Vorteile eines „Agenten in Ihrer Tasche, der vollständig in die Regierung der Vereinigten Staaten integriert ist“ verlauten.Als ich die Schlagzeilen las, die an Altman anzuknüpfen schienen, war mein erster Instinkt, den Durst der Schlagzeilenschreibenden nach etwas Sexuellem zu tadeln, um die Leser zu ködern. Mein zweiter Instinkt war, den Unternehmen hinter den Algorithmen die Schuld zu geben, einschließlich der KI-Unternehmen, deren Chatbots durch veröffentlichtes Material trainiert werden. Wurde ich zur Komplizin des KI-Unternehmens?Vielleicht war mein Buch mehr eine Zusammenarbeit, als mir bewusst war – nicht weil ein KI-Produkt mir geholfen hatte, mich auszudrücken, sondern weil ich den Unternehmen, die hinter diesen Produkten stehen, bei ihren eigenen Zielen geholfen hatte. In meinem Buch geht es darum, wie die Mächtigen unsere Sprache zu ihrem Vorteil ausnutzen und um unsere Mitschuld daran. Nun schien es, als sei das öffentliche Leben meines Buches selbst in diese Dynamik verwickelt. Es war eine beängstigende Erfahrung, aber ich hätte damit rechnen müssen: Natürlich gab es keinen Grund, mein Buch von einer Ausbeutung auszunehmen, die den ganzen Globus erfasst hat. Ich habe laut darüber nachgedacht, wie es weitergehen könnte: Wie könnten wir unsere Regierungen dazu bringen, den Reichtum und die Macht der Großtechnologie sinnvoll einzuschränken? Wie könnten wir Technologien so finanzieren und entwickeln, dass sie unseren Bedürfnissen und Wünschen dienen, ohne in Ausbeutung verstrickt zu sein?Ich hatte mir vorgestellt, dass mein rhetorischer Machtkampf gegen Big Tech auf den Seiten meines Buches begonnen und beendet worden war. Das war er aber eindeutig nicht. Wenn jene Schlagzeilen das tatsächliche Ende des Kampfes darstellten, würde das bedeuten, dass ich verloren hatte. Und doch hörte ich schon bald von Lesern, die sagten, das Buch habe ihnen das Gefühl gegeben, am Aufstieg von Big Tech mitschuldig zu sein und sie dazu bewegt, als Reaktion auf dieses Gefühl zu handeln. Einige haben ihre Amazon Prime-Abonnements gekündigt, ein anderer hat aufgehört, intime persönliche Ratschläge von ChatGPT einzuholen. Der Kampf geht weiter und es wird Zusammenarbeit erforderlich sein – unter Menschen.